大家好,我是Jack Bytes,一个专注于将人工智能应用于日常生活的半吊子程序猿,平时主要分享AI、NAS、Docker、搞机技巧、开源项目等。

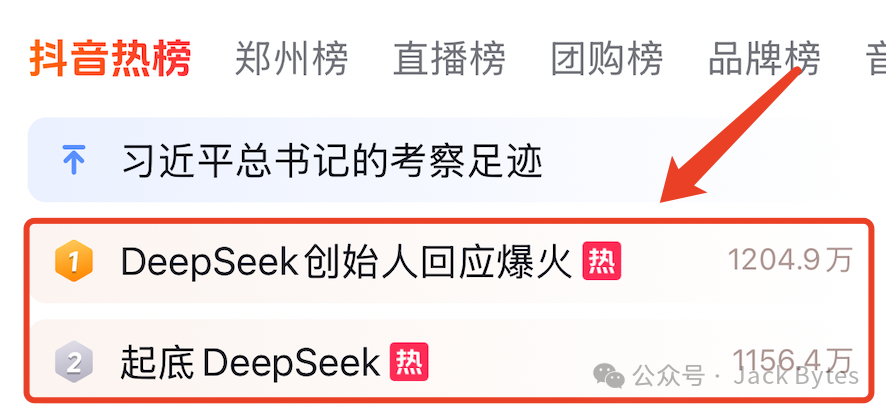

兄弟们,太炸裂了,不知道你们最近是不是被DeepSeek发布的R1模型刷屏了。

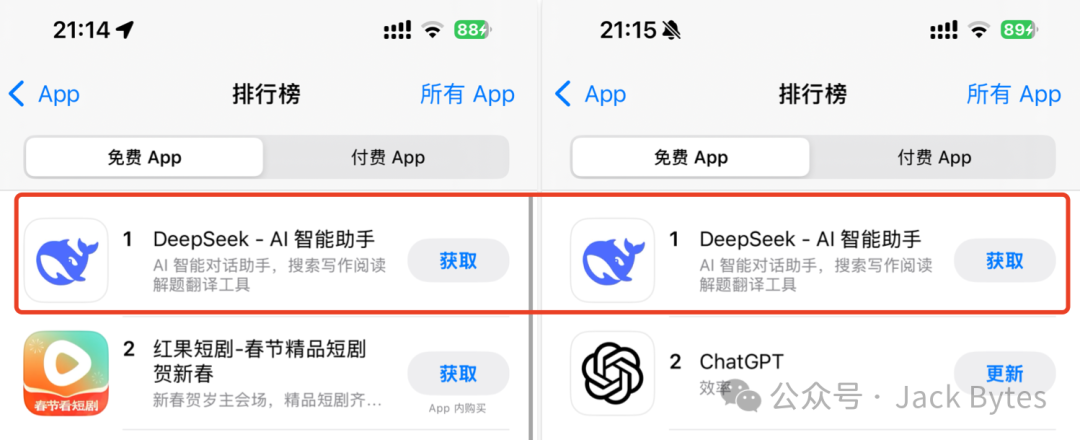

据说DeepSeek R1模型用更低的训练成本,全方位逼近甚至超越OpenAI的o1模型,并且其APP也登上了中国和美国苹果应用商店免费榜的第一名。

相比于CloseAI,DeepSeek开源了其模型权重,使得普通人也可以在家用电脑上进行部署。

今天,手把手教大家在本地部署DeepSeek R1,并将其集成到Dify中,实打实提升你的工作效率!

一、模型部署

在本节中,主要介绍如何在本地通过ollama部署DeepSeek R1。后面的章节将介绍如何将其集成到Dify中。

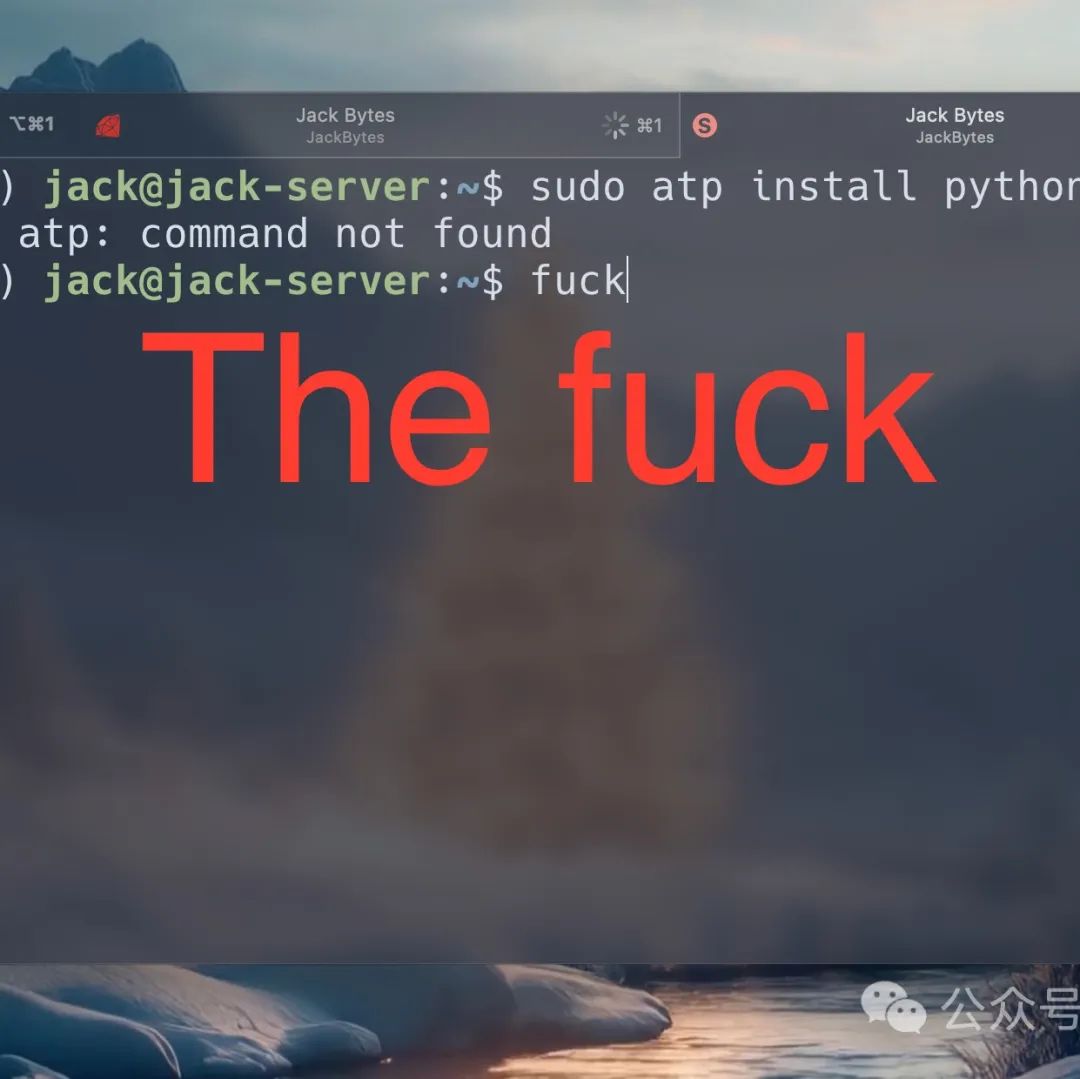

1.1 ollama安装

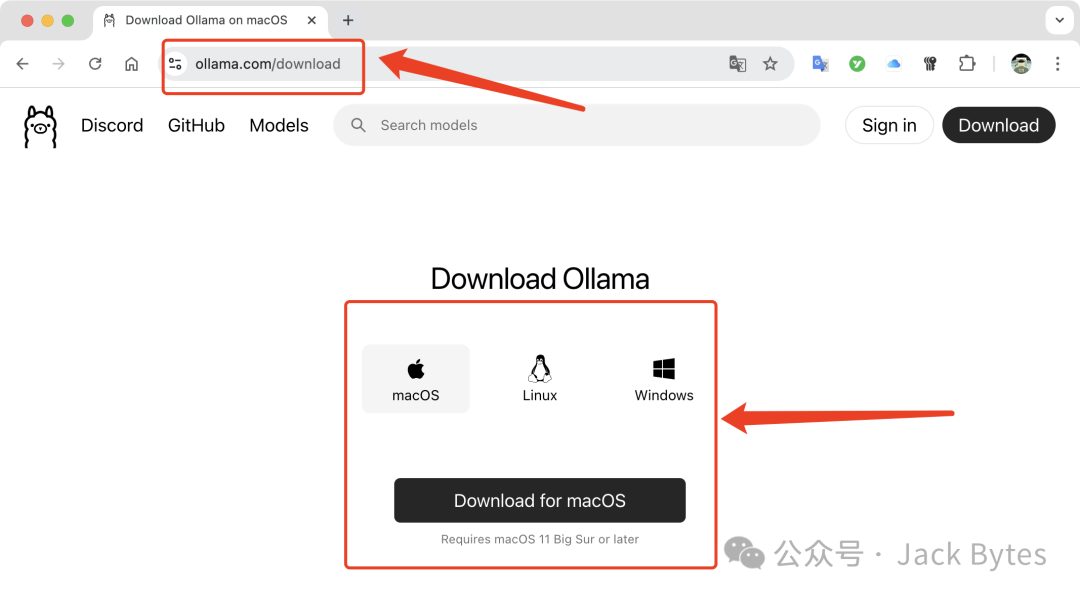

进入到ollama官网,选择对应的操作系统,下载ollama应用程序并安装:

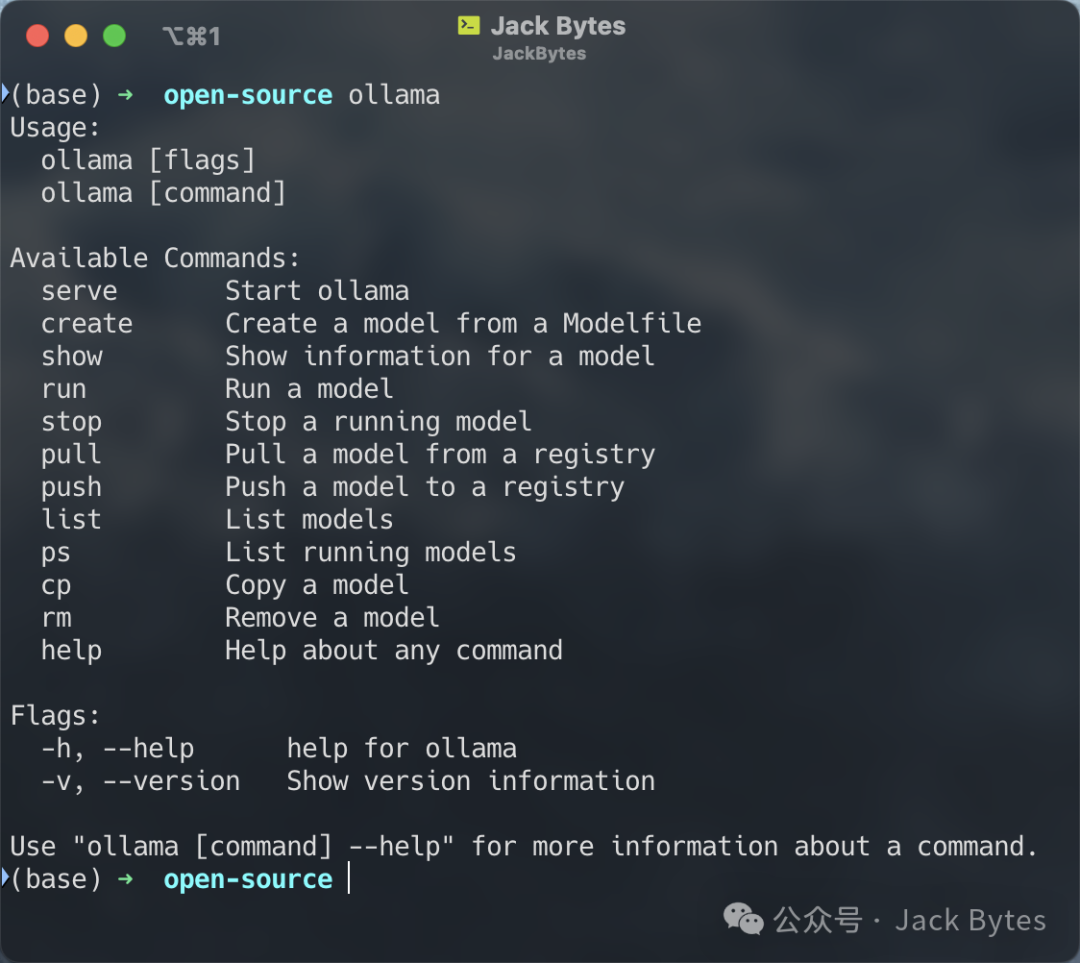

安装成功之后,在命令行输入ollama,如果出现下面的提示,则说明安装成功。

1.2 模型部署

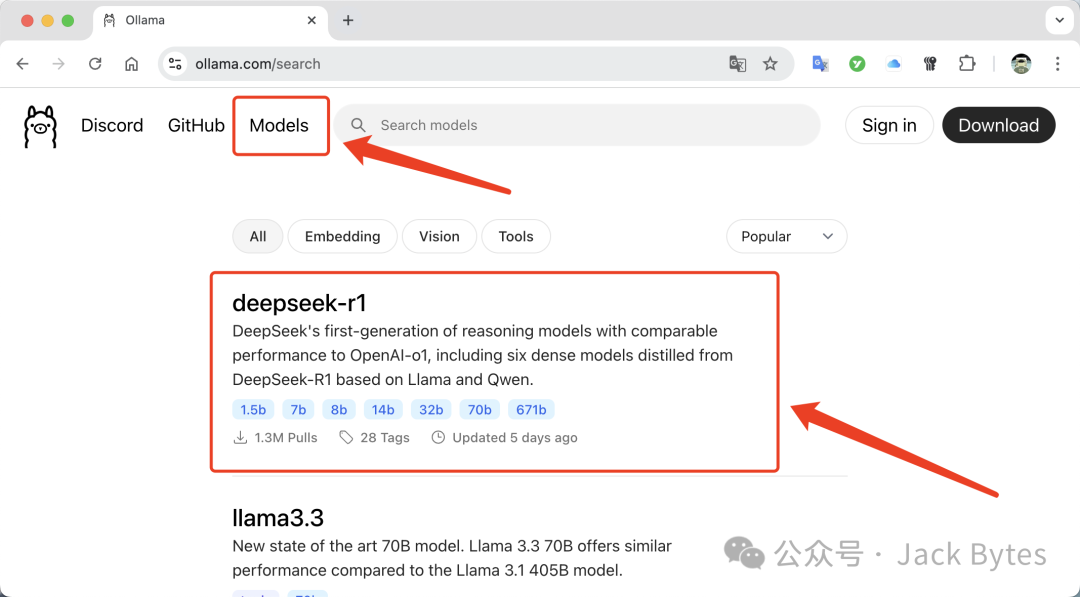

在ollama官网的顶部,点击「Models」,然后选择第一个「DeepSeek R1」:

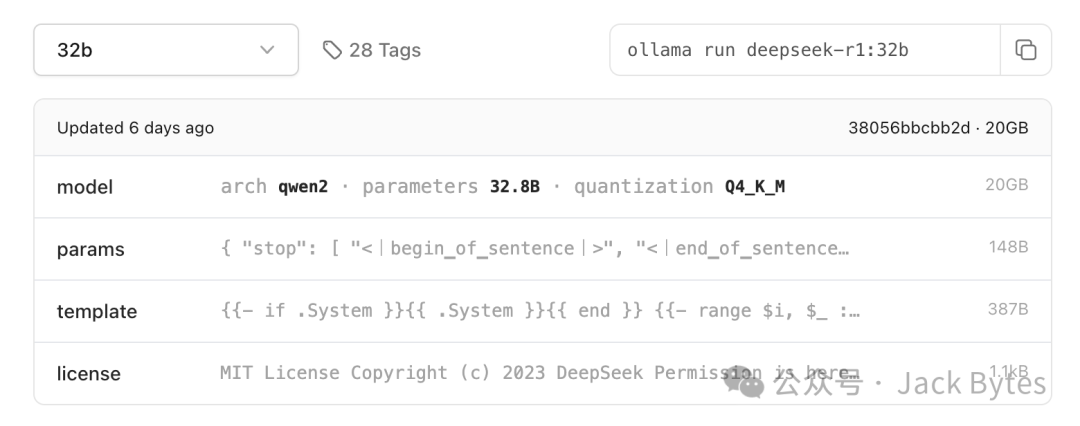

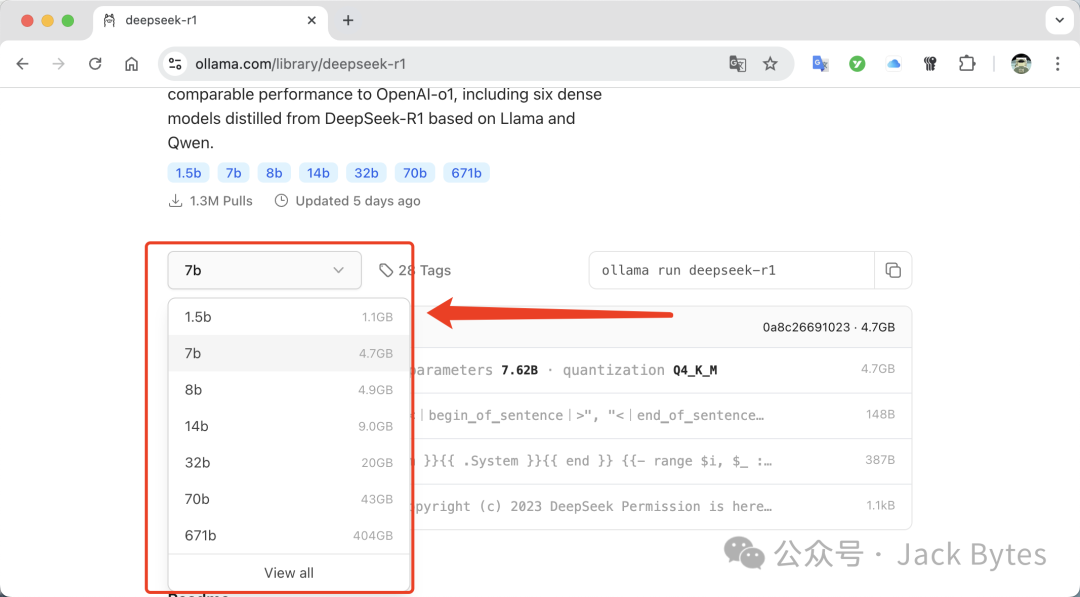

在模型界面,根据自己的显存大小选择对应的版本:

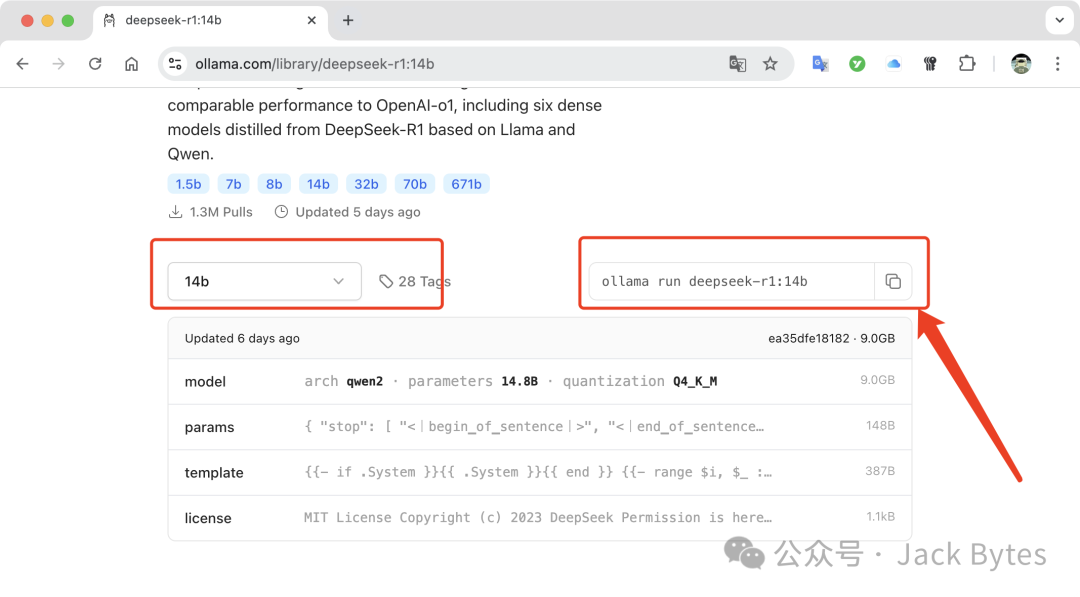

比如,我的电脑是MacOS 32G,这里我选择了14b的模型,点击14b,然后在右侧会出现下载命令:

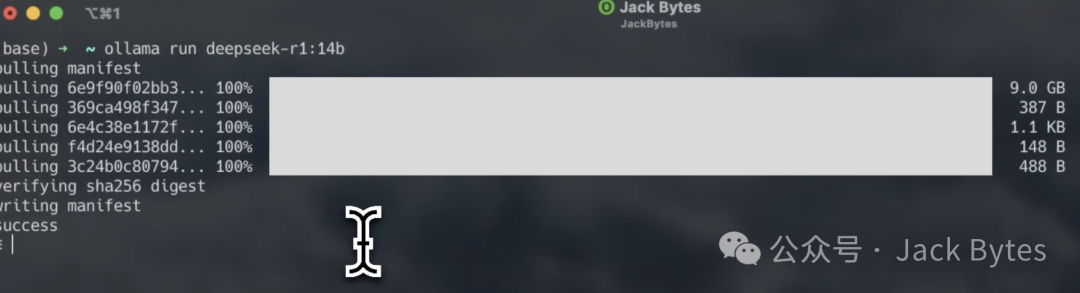

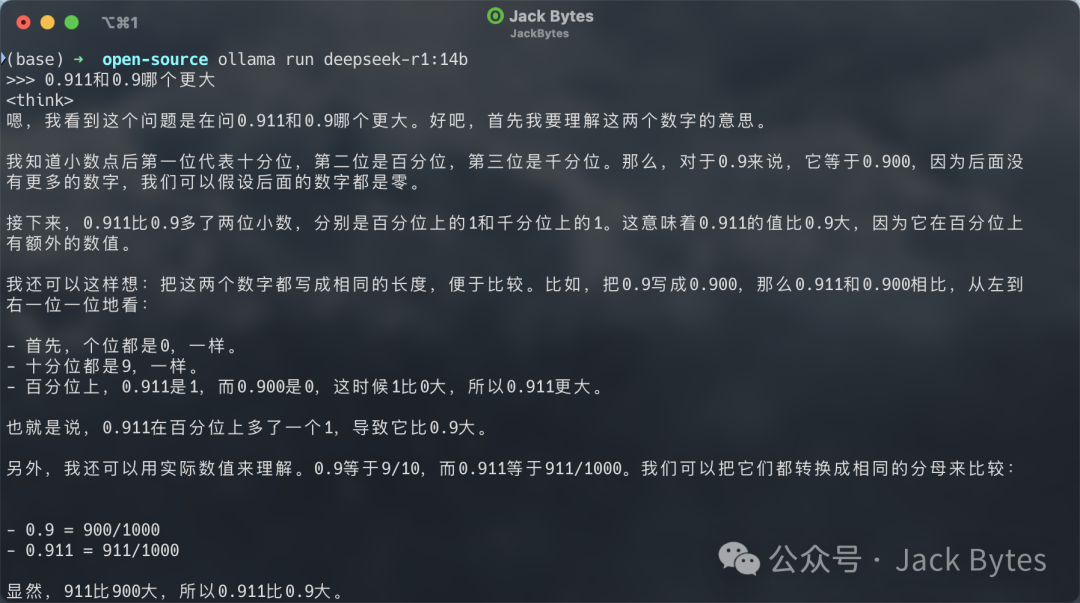

命令执行完成之后,就可以通过命令行和大模型进行对话了:

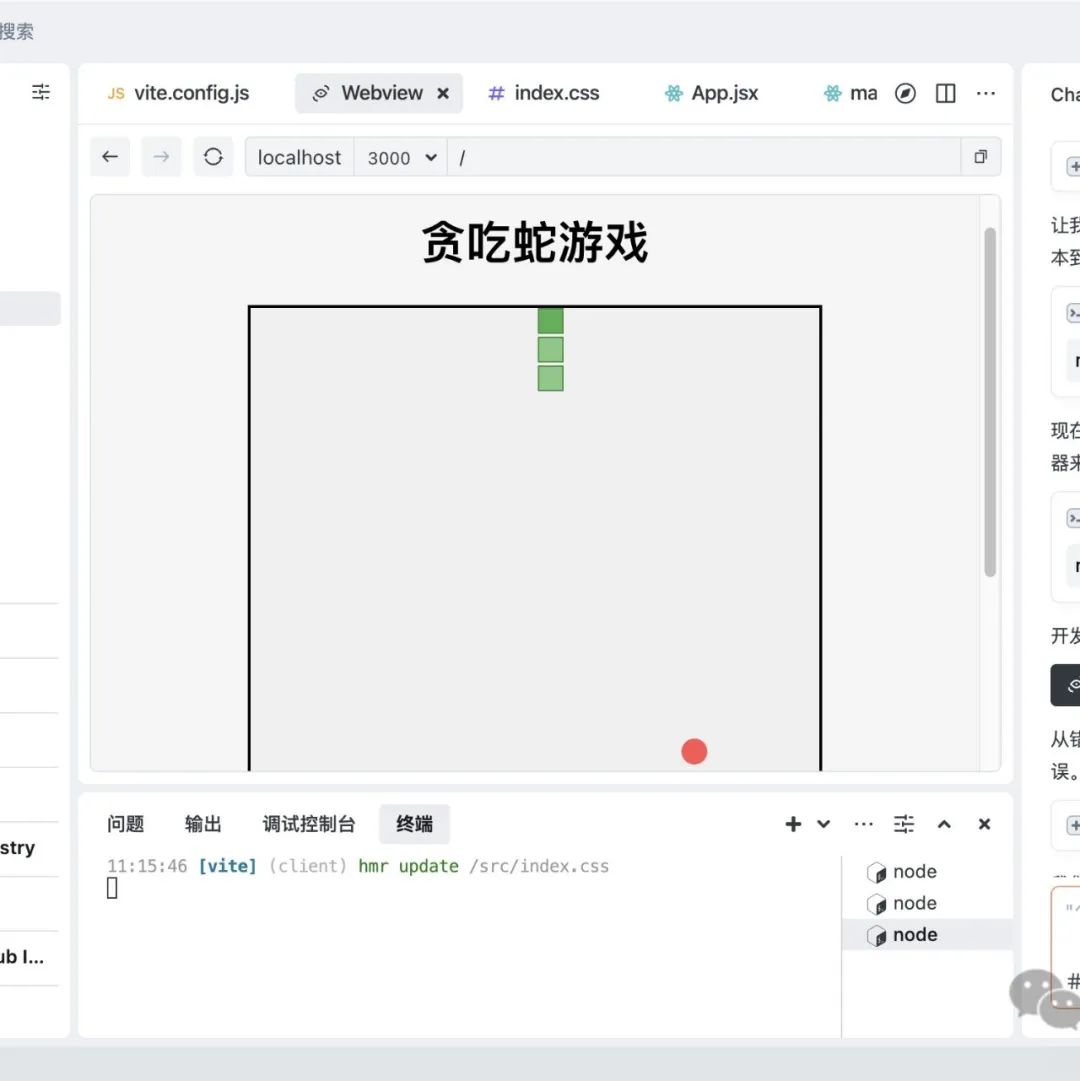

当然,只是通过命令和大模型进行对话还是不太方便了点,那么接下来,介绍一下如何将其集成到Dify中,通过可视化的方式进行调用。

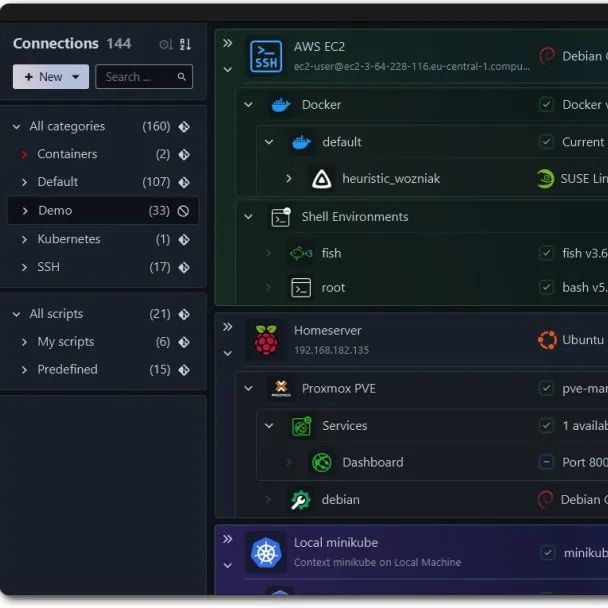

二、在Dify中配置DeepSeek R1

Dify的部署过程这里不再赘述了,感兴趣的可以看我往期的文章《群晖NAS+Dify:AI原生应用部署教程,解锁大模型智能与工作流新境界》。

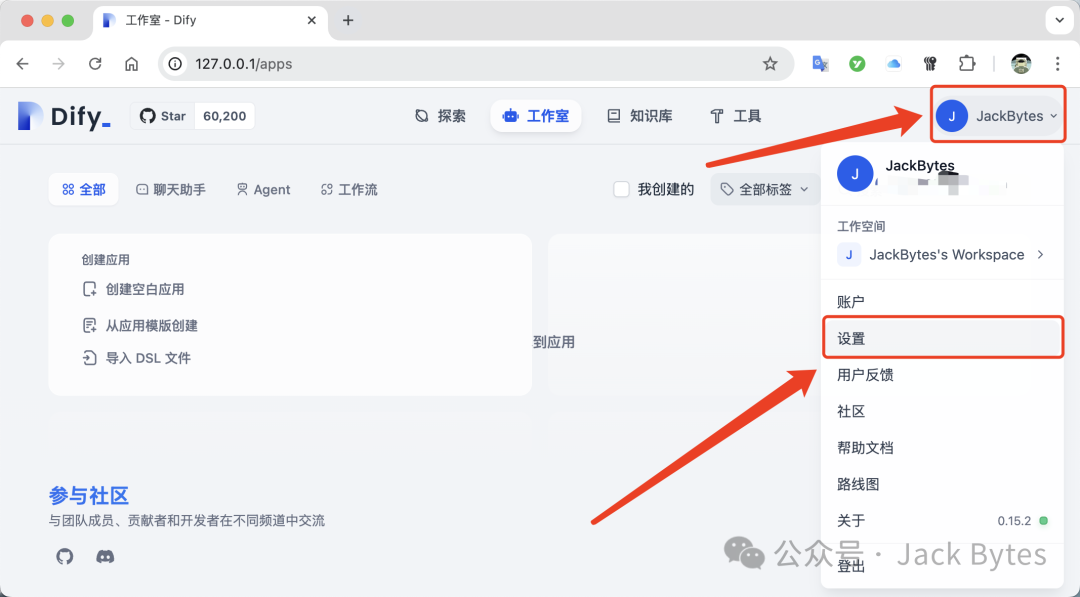

登录到已经部署好的Dify中,点击右上角的头像,然后点击设置:

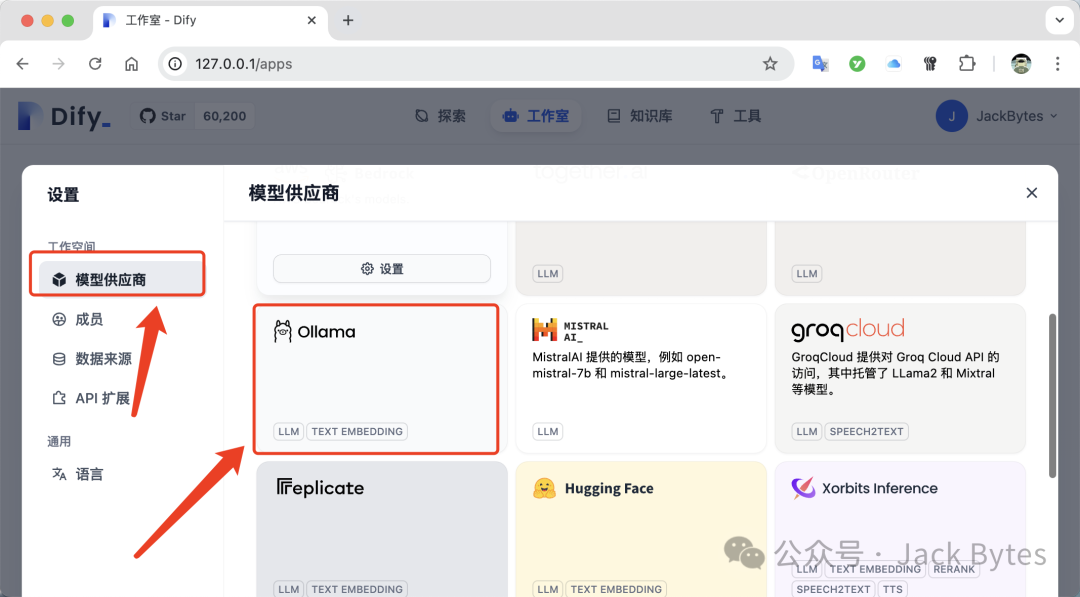

在「模型供应商」界面中选择「ollama」:

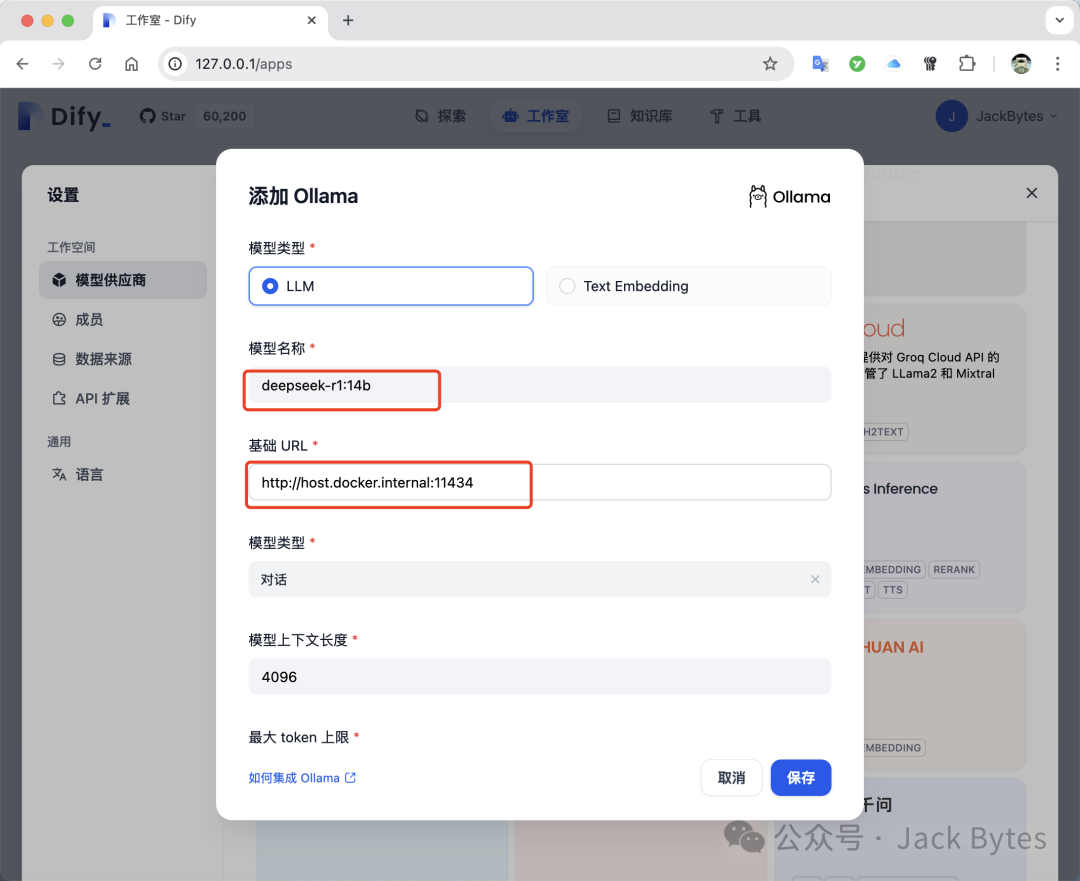

在「模型名称」中填:deepseek-r1:14b。在「基础URL中」,如果ollama和Dify是同机部署,并且Dify是通过Docker部署,那么填http://host.docker.internal:11434,其他情况填http://ollama的地址:11434,填完之后点击保存即可。

三、创建应用

下面介绍一下在Dify中创建一个应用来使用DeepSeek R1模型。

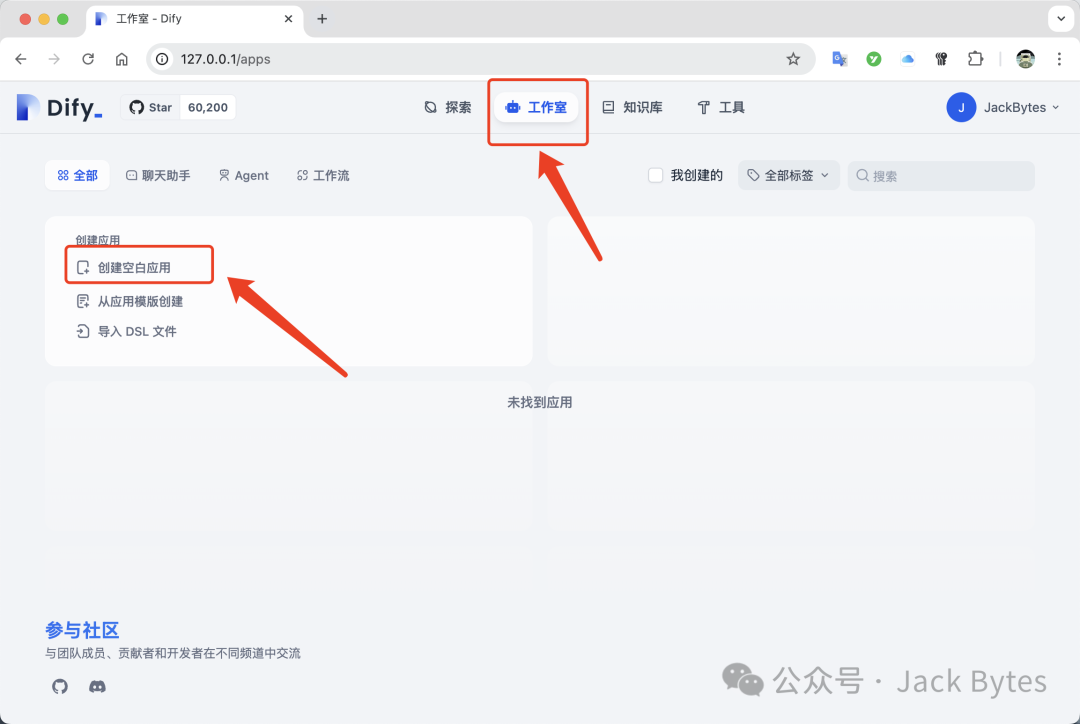

在Dify的「工作室」中点击「创建空白应用」

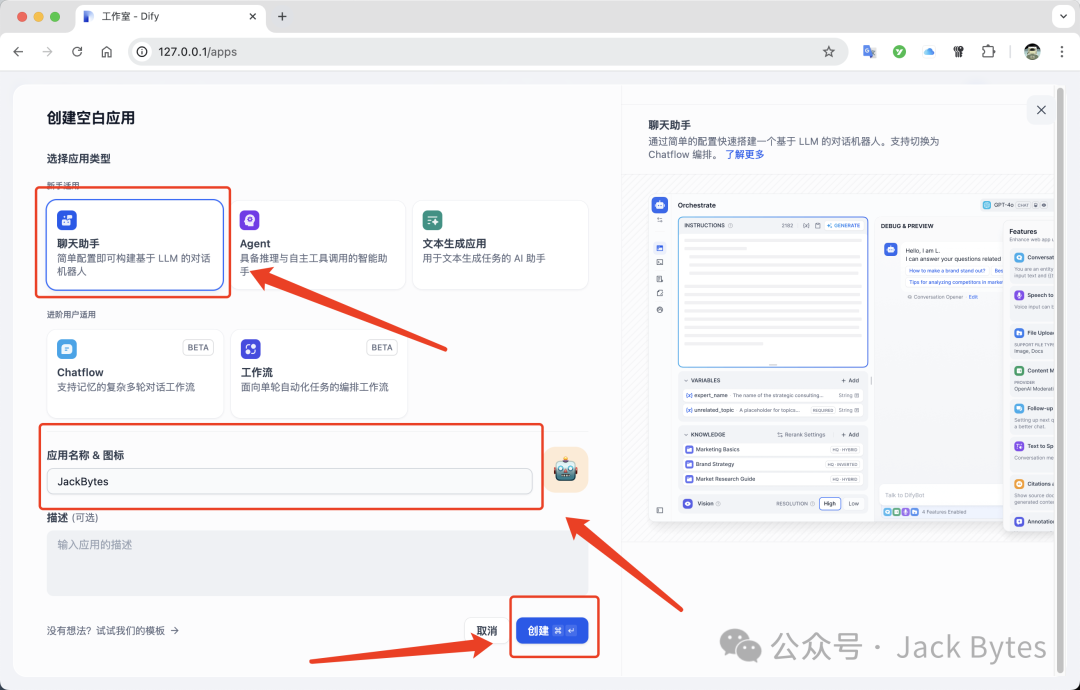

在弹出的窗口中选择「聊天助手」,填写「应用名称」和「描述」,然后点击创建:

创建完成之后,在右上角选择添加好的DeepSeek R1模型:

下面进行提问试试:

需要注意的是,DeepSeek R1是一个推理模型,不支持函数调用,也就是说无法集成在DIfy的智能体中,但是DeepSeek V3可以。

四、总结

本文介绍了当前刷屏的DeepSeek R1模型,并教大家如何在本地进行部署,然后集成到Dify中,感兴趣的可以试试。

如果对此类教程感兴趣的话,欢迎Mark,后续会持续更新~

我是Jack Bytes

一个专注于将人工智能应用于日常生活的半吊子程序猿!

平时主要分享AI、NAS、Docker、搞机技巧、开源项目等技术,喜欢的话请关注吧!

往期内容

Happy New Year

2025-01-27

2025-01-26

2025-01-24

2025-01-22

2025-01-21

2025-01-18

2025-01-12

2025-01-10

2025-01-08

本文来自Jack Bytes,本文观点不代表 PmTemple 立场,转载请联系原作者。原文链接:

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫